Post: Galleria de imagens geradas por IA

...

Criado em Fevereiro de 2026 por Maxwell Anderson

Este material é destinado a alunos que estão iniciando sua jornada no suporte técnico. Aqui, vamos desmistificar termos como “arquivo”, “RAM” e “sistema operacional”, conectando a história aos componentes modernos que montamos hoje.

Antes de abrirmos um computador, precisamos entender o que acontece “dentro” dos chips:

A informática nasceu da necessidade de precisão. O Ábaco (3000 a.C.) foi o primeiro “hardware” de cálculo. Séculos depois, em 1642, Blaise Pascal criou a Pascalina, uma calculadora mecânica de engrenagens para somar e subtrair.

Detalhamento histórico:

A história da computação é, fundamentalmente, a história da busca pela precisão. O início dessa jornada remonta à Suméria em 4000 a.C., onde o registro de transações comerciais em tabletes de argila estabeleceu a necessidade de persistência de dados.

A invenção do ábaco na Babilônia, por volta de 3000 a.C., representou a primeira interface de hardware dedicada ao processamento aritmético, utilizando a posição física de objetos para representar valores numéricos.

No século XIX, Charles Babbage projetou duas máquinas fundamentais:

Máquina Diferencial: Focada em calcular tabelas matemáticas sem erros humanos.

Contexto histórico:

A Máquina Analítica foi o primeiro computador programável de propósito geral jamais concebido, antecedendo os computadores eletrônicos por mais de um século. Seu design separou o conceito de processamento (executar operações) do armazenamento (guardar dados), um princípio que permanece no cerne da arquitetura de Von Neumann e dos computadores modernos.

Máquina Analítica: O verdadeiro antepassado do PC moderno. Ela já separava o processamento (“moinho”) do armazenamento (“armazém”).

Ada Lovelace, colega de Babbage, percebeu que essa máquina poderia processar mais do que números, incluindo música e símbolos, tornando-se a primeira programadora da história ao escrever o primeiro algoritmo.

Contexto histórico:

No entanto, o salto para a automação real ocorreu apenas no século XVII. Blaise Pascal, em 1642, desenvolveu a Pascalene, um dispositivo de engrenagens projetado para auxiliar seu pai em cálculos fiscais.[1] Embora a Pascalene fosse limitada a operações de adição e subtração e apresentasse baixa confiabilidade mecânica, ela introduziu o conceito de transporte automático de dígitos, o precursor do “carry” em somadores binários modernos.[2] Gottfried Wilhelm von Leibniz aprimorou essa visão em 1673 com a invenção da Step Reckoner, que utilizava o princípio do tambor escalonado para realizar as quatro operações aritméticas e extrair raízes quadradas, consolidando a mecânica como um meio viável para a execução de algoritmos complexos.[2]

Babbage, frequentemente referido como o pai da computação, projetou em 1834 um sistema que separava o processamento (o “moinho”) do armazenamento (o “armazém”).[1] A colaboração de Ada Lovelace foi fundamental neste período; Lovelace não apenas escreveu o primeiro programa de computador para calcular os números de Bernoulli, mas também discerniu que o hardware poderia processar mais do que apenas valores numéricos, podendo representar qualquer entidade simbólica, de música a gráficos.[6]

| Marco Histórico | Inventor | Inovação Técnica | Implicação para o Hardware |

|---|---|---|---|

| 1642 | Blaise Pascal | Pascalene | Mecanismo de engrenagens para transporte de dígitos [1] |

| 1673 | Gottfried Leibniz | Step Reckoner | Implementação mecânica das quatro operações [3] |

| 1804 | Joseph Jacquard | Cartões Perfurados | Primeiro sistema de controle programável por hardware [3] |

| 1834 | Charles Babbage | Máquina Analítica | Arquitetura com separação entre CPU e Memória [1] |

Até a década de 1940, usavam-se Relés (interruptores barulhentos e lentos). A revolução veio com as Válvulas Eletrônicas: elas não tinham peças móveis e eram muito mais rápidas, mas esquentavam como lâmpadas e queimavam com frequência.

O primeiro computador eletrônico de grande escala.

Peso: 30 toneladas.

Componentes: Mais de 18.000 válvulas.

Manutenção: Era um pesadelo técnico. O calor gerado (174.000 watts) exigia ar-condicionado industrial, e as válvulas precisavam ser trocadas quase diariamente.

Contexto histórico:

Do ponto de vista de manutenção, o ENIAC representava um desafio hercúleo. O sistema ocupava uma área de aproximadamente 180 metros quadrados e pesava 30 toneladas.[10] Com mais de 18.000 válvulas operando simultaneamente, o calor gerado chegava a 174.000 watts, exigindo sistemas de ventilação industriais e salas especialmente projetadas para evitar o colapso térmico.[12] A manutenção preventiva consistia na substituição constante de válvulas que queimavam diariamente devido ao estresse térmico. A programação, por sua vez, era uma tarefa física de montagem e desmontagem, exigindo que operadores reorganizassem cabos de conexão e ajustassem milhares de interruptores manuais para configurar cada nova tarefa.[12]

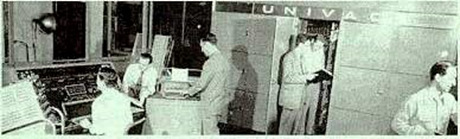

Foi o primeiro computador comercial. Ele trouxe uma inovação que usamos até hoje para backups: a Fita Magnética. Ele operava com um clock de 2,25 MHz e pesava cerca de 7,6 toneladas, bem menos que seu antecessor.

Contexto histórico:

O UNIVAC I (Universal Automatic Computer), lançado em 1951, foi o primeiro computador projetado especificamente para aplicações comerciais e administrativas nos Estados Unidos.[13] Diferente do ENIAC, o UNIVAC utilizava fita magnética para entrada e saída de dados, o que permitia uma densidade de armazenamento muito superior aos cartões perfurados.[12] Em termos de especificações técnicas, o UNIVAC utilizava 6.103 válvulas e operava com um clock de 2,25 MHz, sendo capaz de realizar cerca de 1.905 operações por segundo.[13] A memória era baseada em linhas de atraso de mercúrio, que armazenavam dados na forma de ondas acústicas, uma técnica que exigia um controle rigoroso de temperatura para manter a integridade dos bits.[11]

| Especificação Técnica | ENIAC (1946) | UNIVAC I (1951) |

|---|---|---|

| Quantidade de Válvulas | 18.000+ [12] | ~6.100 [13] |

| Peso Total | 30 toneladas [11] | ~7,6 toneladas [13] |

| Consumo de Potência | 150-174 kW [11] | 125 kW [11] |

| Frequência de Clock | 100 kHz [12] | 2,25 MHz [13] |

| Memória Principal | 20 números [12] | 1.000 palavras (12 char cada) [13] |

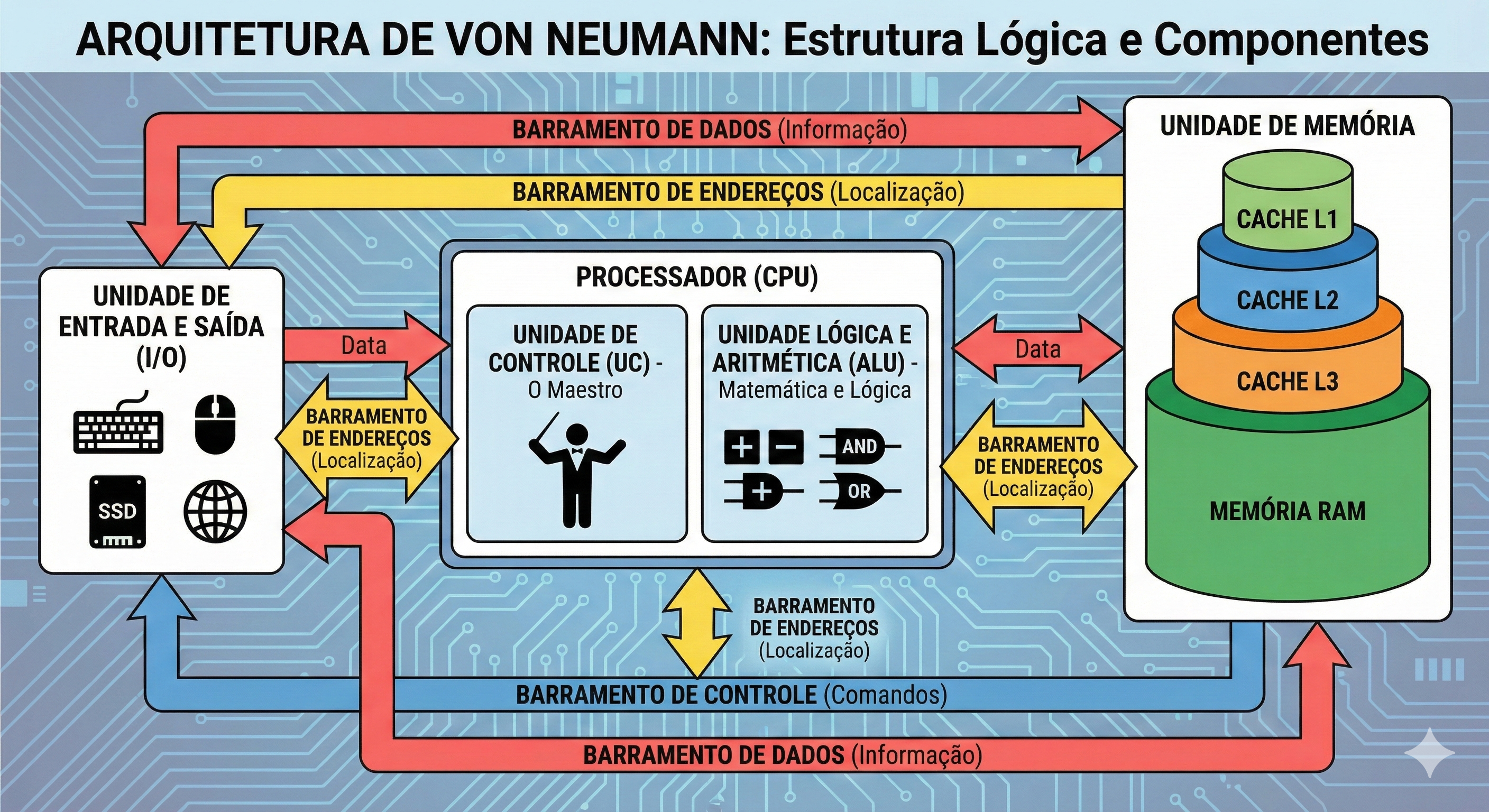

A montagem e manutenção de computadores modernos baseiam-se quase inteiramente na Arquitetura de Von Neumann, formalizada em 1945. Este modelo introduziu o conceito de “programa armazenado”, onde tanto as instruções do software quanto os dados processados residem na mesma unidade de memória física.[15] Antes disso, as máquinas tinham funções fixas ou exigiam reconfiguração física total.

A estrutura lógica de um sistema baseado em Von Neumann é composta por cinco unidades essenciais:

Um aspecto crítico para o técnico de hardware é o “Gargalo de Von Neumann”. Como as instruções e os dados compartilham o mesmo barramento e memória, a CPU muitas vezes precisa esperar que os dados sejam buscados antes de processar a próxima instrução, o que limita o desempenho máximo do sistema.[18] A arquitetura Harvard, em contraste, utiliza barramentos e memórias separadas para dados e instruções, sendo comum em caches internos de processadores modernos e microcontroladores para evitar este gargalo.[18]

Enquanto Von Neumann focava na estrutura organizacional, Alan Turing concentrou-se na eficiência algorítmica e na flexibilidade lógica. Em 1945, Turing propôs o ACE, que apresentava um design significativamente diferente e, teoricamente, mais rápido que o EDVAC de Von Neumann.[19] Turing introduziu a “programação ótima”, onde as instruções eram posicionadas na memória de linha de atraso de mercúrio de forma que estivessem prontas para leitura exatamente no momento em que a CPU as solicitava, minimizando a latência de rotação da memória.[14] Embora o design original de Turing fosse complexo demais para as capacidades de engenharia da época, o Pilot ACE de 1950 tornou-se o computador mais rápido do mundo em seu lançamento, operando a 1 MHz.[20]

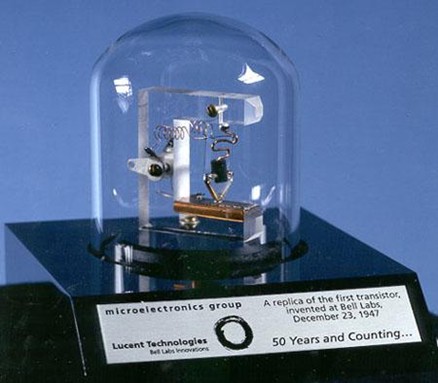

A substituição das válvulas pelos transistores em 1947, nos Laboratórios Bell, marcou o início da segunda geração de computadores e transformou radicalmente a manutenção de hardware.[8] John Bardeen, Walter Brattain e William Shockley desenvolveram o transistor de contato de ponto utilizando germânio, um material semicondutor que podia atuar tanto como condutor quanto como isolante.[21]

Os transistores trouxeram vantagens decisivas: eram menores, consumiam uma fração da energia das válvulas, não exigiam aquecimento e tinham uma vida útil muito superior.[5] Isso permitiu que os computadores diminuíssem de tamanho, passando de salas inteiras para gabinetes de tamanho médio. A terceira geração surgiu no final dos anos 1950 com os Circuitos Integrados (ICs), onde múltiplos transistores e outros componentes eram fabricados em uma única pastilha de silício.[5] Finalmente, a quarta geração consolidou a CPU em um único chip, o microprocessador, permitindo a revolução dos computadores pessoais (PCs) na década de 1970.[5]

O armazenamento de dados evoluiu de métodos mecânicos e magnéticos rudimentares para soluções de estado sólido de alta densidade. O UNIVAC I iniciou a era da fita magnética, que oferecia velocidades de leitura de aproximadamente 12.800 caracteres por segundo, uma inovação monumental frente aos cartões perfurados.[13]

Durante décadas, o Disco Rígido (HDD) foi o padrão de armazenamento secundário. Baseado em pratos magnéticos rotativos e cabeças de leitura físicas, o HDD enfrentava limitações térmicas e mecânicas, com velocidades que dificilmente ultrapassavam 200 MB/s.[23] A introdução dos SSDs (Solid State Drives) baseados em flash NAND eliminou a latência mecânica, mas os modelos iniciais eram limitados pela interface SATA, originalmente projetada para HDDs, com teto de 600 MB/s.[24]

Em 2026, o protocolo NVMe (Non-Volatile Memory Express) é o padrão absoluto para sistemas de alta performance. Diferente do SATA, o NVMe comunica-se diretamente com o processador através do barramento PCIe (Peripheral Component Interconnect Express), permitindo paralelismo massivo com milhares de filas de comandos simultâneos.[23]

| Interface de Armazenamento | Protocolo | Barramento | Velocidade Máxima Típica (2026) |

|---|---|---|---|

| HDD / SSD SATA | SATA III | SATA | 600 MB/s [24] |

| NVMe Gen 3 | NVMe | PCIe 3.0 x4 | ~3.500 MB/s [25] |

| NVMe Gen 4 | NVMe | PCIe 4.0 x4 | ~7.500 MB/s [25] |

| NVMe Gen 5 | NVMe | PCIe 5.0 x4 | ~14.500 MB/s [26] |

| SD Express 8.0 | NVMe | PCIe 4.0 x2 | ~4.000 MB/s [28] |

Hoje, não trocamos válvulas, mas lidamos com a Miniaturização. O substituto da válvula foi o Transistor (1947), que permitiu colocar bilhões de interruptores em um único chip de silício.

Calor e Performance: Assim como o ENIAC sofria com calor, nossos SSDs NVMe Gen5 atuais chegam a velocidades de 14.500 MB/s e esquentam tanto que precisam de dissipadores de calor ativos (com ventoinhas) para não travarem.

A Crise de Componentes de 2026: Como técnicos, devemos avisar aos clientes que os preços de Memória RAM (DDR5/DDR6) e SSDs subiram até 60% este ano devido à alta demanda por Inteligência Artificial.

Upgrade Estratégico: Em 2026, HDDs mecânicos são usados apenas para “depósito” de arquivos pesados (fotos/vídeos). Para o Windows e programas, o uso de SSDs NVMe é obrigatório para evitar lentidão extrema.

Dica do Professor: Entender o passado nos ajuda a diagnosticar o futuro. Um erro de leitura em uma fita magnética de 1951 tem a mesma lógica de um erro de setor em um SSD moderno: a busca pela integridade do dado!